En Resumen

- El nuevo modelo Orion de OpenAI alcanza niveles de rendimiento de GPT-4 al 20% de su entrenamiento, pero con menores mejoras incrementales comparado con modelos anteriores.

- OpenAI enfrenta una limitación de datos de calidad para entrenar modelos y explora la generación de datos sintéticos y el desarrollo de modelos avanzados de razonamiento como posibles soluciones.

- La empresa divide su desarrollo en dos líneas: la Serie-O, enfocada en razonamiento intensivo, y Orion para tareas de lenguaje generales, con la intención de converger ambas en el futuro.

El próximo modelo de inteligencia artificial de OpenAI está generando menores ganancias de rendimiento que sus predecesores, según informaron a The Information fuentes familiarizadas con el asunto.

Las pruebas realizadas por empleados revelan que Orion alcanzó el nivel de rendimiento de GPT-4 después de completar solo el 20% de su entrenamiento, según The Information.

El aumento de calidad de GPT-4 a la versión actual de GPT-5 parece ser menor que el que hubo de GPT-3 a GPT-4.

"Algunos investigadores de la empresa creen que Orion no es consistentemente mejor que su predecesor en el manejo de ciertas tareas, según los empleados (de OpenAI)", informó The Information. "Orion tiene mejor desempeño en tareas de lenguaje, pero puede no superar a los modelos anteriores en tareas como la programación, según un empleado de OpenAI".

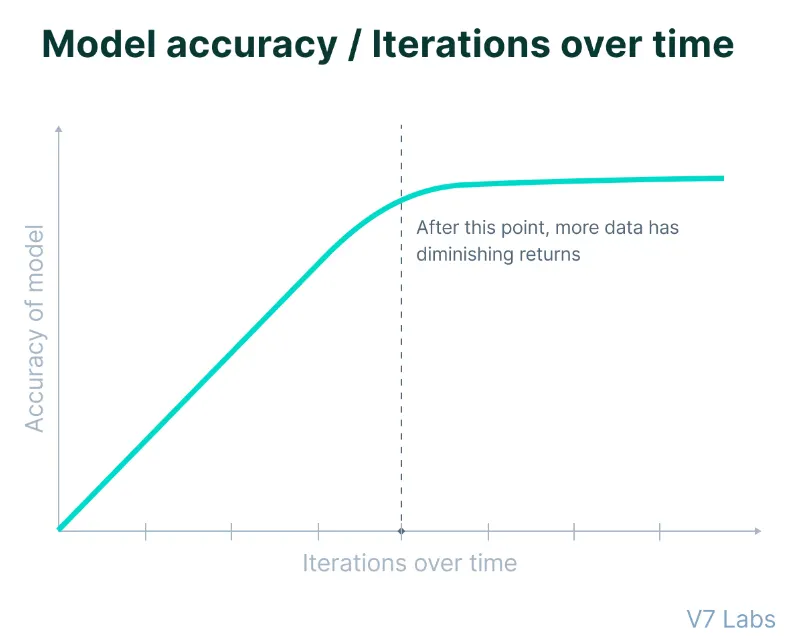

Si bien puede parecer impresionante para algunos que Orion se acerque a GPT-4 con solo el 20% de su entrenamiento, es importante señalar que las primeras etapas del entrenamiento de IA típicamente producen las mejoras más dramáticas, con las fases posteriores generando ganancias más pequeñas.

Por lo tanto, el 80% restante del tiempo de entrenamiento probablemente no producirá la misma magnitud de avance vista en saltos generacionales previos, dijeron las fuentes.

Las limitaciones surgen en un momento crítico para OpenAI tras su reciente ronda de financiación de $6.600 millones.

La empresa ahora enfrenta mayores expectativas de los inversores mientras lidia con restricciones técnicas que desafían los enfoques tradicionales de escalamiento en el desarrollo de IA. Si estas versiones tempranas no cumplen con las expectativas, los próximos esfuerzos de recaudación de fondos de la empresa podrían no encontrar el mismo entusiasmo que antes, y eso podría ser un problema para una empresa potencialmente con fines de lucro, que es lo que Sam Altman parece querer para OpenAI.

Los resultados poco alentadores apuntan a un desafío fundamental que enfrenta toda la industria de IA: la disminución en el suministro de datos de entrenamiento de alta calidad y la necesidad de mantenerse relevante en un campo tan competitivo como la IA generativa.

Una investigación publicada en junio predijo que las empresas de IA agotarán los datos de texto generados por humanos disponibles públicamente entre 2026 y 2032, marcando un punto de inflexión crítico para los enfoques tradicionales de desarrollo.

"Nuestros hallazgos indican que las tendencias actuales de desarrollo de LLM no pueden sostenerse únicamente mediante el escalamiento convencional de datos", afirma el documento de investigación, destacando la necesidad de enfoques alternativos para mejorar los modelos, incluyendo la generación de datos sintéticos, el aprendizaje por transferencia desde dominios ricos en datos y el uso de datos no públicos.

La estrategia histórica de entrenar modelos de lenguaje con textos disponibles públicamente de sitios web, libros y otras fuentes ha llegado a un punto de rendimientos decrecientes, habiendo los desarrolladores "exprimido en gran medida todo lo que pueden de ese tipo de datos", según The Information.

Cómo OpenAI está Abordando Este Problema: Razonamiento vs. Modelos de Lenguaje

Para enfrentar estos desafíos, OpenAI está reestructurando fundamentalmente su enfoque al desarrollo de IA.

"En respuesta al reciente desafío de las leyes de escalamiento basadas en entrenamiento planteado por la desaceleración de las mejoras de GPT, la industria parece estar dirigiendo sus esfuerzos a mejorar los modelos después de su entrenamiento inicial, potencialmente generando un tipo diferente de ley de escalamiento", según The Information.

Para lograr este estado de mejora continua, OpenAI está separando el desarrollo de modelos en dos vías distintas:

La Serie-O (que parece tener el nombre en código Strawberry), centrada en capacidades de razonamiento, representa una nueva dirección en la arquitectura de modelos. Estos modelos operan con una intensidad computacional significativamente mayor y están diseñados explícitamente para tareas complejas de resolución de problemas.

Las demandas computacionales son sustanciales, con estimaciones iniciales que sugieren costos operativos seis veces mayores que los modelos actuales. Sin embargo, las capacidades mejoradas de razonamiento podrían justificar el incremento en gastos para aplicaciones específicas que requieren procesamiento analítico avanzado.

Este modelo, si es el mismo que Strawberry, también tiene la tarea de generar suficientes datos sintéticos para aumentar constantemente la calidad de los LLMs de OpenAI.

En paralelo, los Modelos Orion o la Serie GPT (considerando que OpenAI registró la marca GPT-5) continúan evolucionando, centrándose en tareas generales de procesamiento y comunicación del lenguaje. Estos modelos mantienen requisitos computacionales más eficientes mientras aprovechan su base de conocimiento más amplia para tareas de escritura y argumentación.

El CPO de OpenAI, Kevin Weil, también confirmó esto durante una sesión de preguntas y respuestas y dijo que espera convergir ambos desarrollos en algún punto en el futuro.

"No es uno u otro, son ambos", respondió cuando se le preguntó si OpenAI se centraría en escalar LLMs con más datos o usar un enfoque diferente, centrándose en modelos más pequeños, pero más rápidos, "mejores modelos base más escalamiento de Strawberry/tiempo de cómputo en inferencia."

¿Solución temporal o definitiva?

El enfoque de OpenAI para abordar la escasez de datos mediante la generación de datos sintéticos presenta desafíos complejos para la industria. Los investigadores de la empresa están desarrollando modelos sofisticados diseñados para generar datos de entrenamiento, sin embargo, esta solución introduce nuevas complicaciones para mantener la calidad y fiabilidad del modelo.

Como informó previamente Decrypt, los investigadores han descubierto que el entrenamiento de modelos con datos sintéticos representa una espada de doble filo. Si bien ofrece una posible solución a la escasez de datos, introduce nuevos riesgos de degradación del modelo y preocupaciones de fiabilidad con una degradación comprobada después de varias iteraciones de entrenamiento.

En otras palabras, a medida que los modelos se entrenan con contenido generado por IA, pueden comenzar a amplificar imperfecciones sutiles en sus resultados. Estos ciclos de retroalimentación pueden perpetuar y magnificar sesgos existentes, creando un efecto acumulativo que se vuelve cada vez más difícil de detectar y corregir.

El equipo de Foundations de OpenAI está desarrollando nuevos mecanismos de filtrado para mantener la calidad de los datos, implementando diferentes técnicas de validación para distinguir entre contenido sintético de alta calidad y potencialmente problemático. El equipo también está explorando enfoques de entrenamiento híbridos que combinan estratégicamente contenido humano y generado por IA para maximizar los beneficios de ambas fuentes mientras minimizan sus respectivas desventajas.

La optimización posterior al entrenamiento también ha ganado relevancia. Los investigadores están desarrollando nuevos métodos para mejorar el rendimiento del modelo después de la fase de entrenamiento inicial, potencialmente ofreciendo una manera de mejorar las capacidades sin depender únicamente de la expansión del conjunto de datos de entrenamiento.

Dicho esto, GPT-5 sigue siendo un embrión de un modelo completo con un importante trabajo de desarrollo por delante. Sam Altman, CEO de OpenAI, ha indicado que no estará listo para su implementación este año ni el próximo. Este cronograma extendido podría resultar ventajoso, permitiendo a los investigadores abordar las limitaciones actuales y potencialmente descubrir nuevos métodos para mejorar GPT-5 antes de su eventual lanzamiento.

Editado por Josh Quittner y Sebastian Sinclair