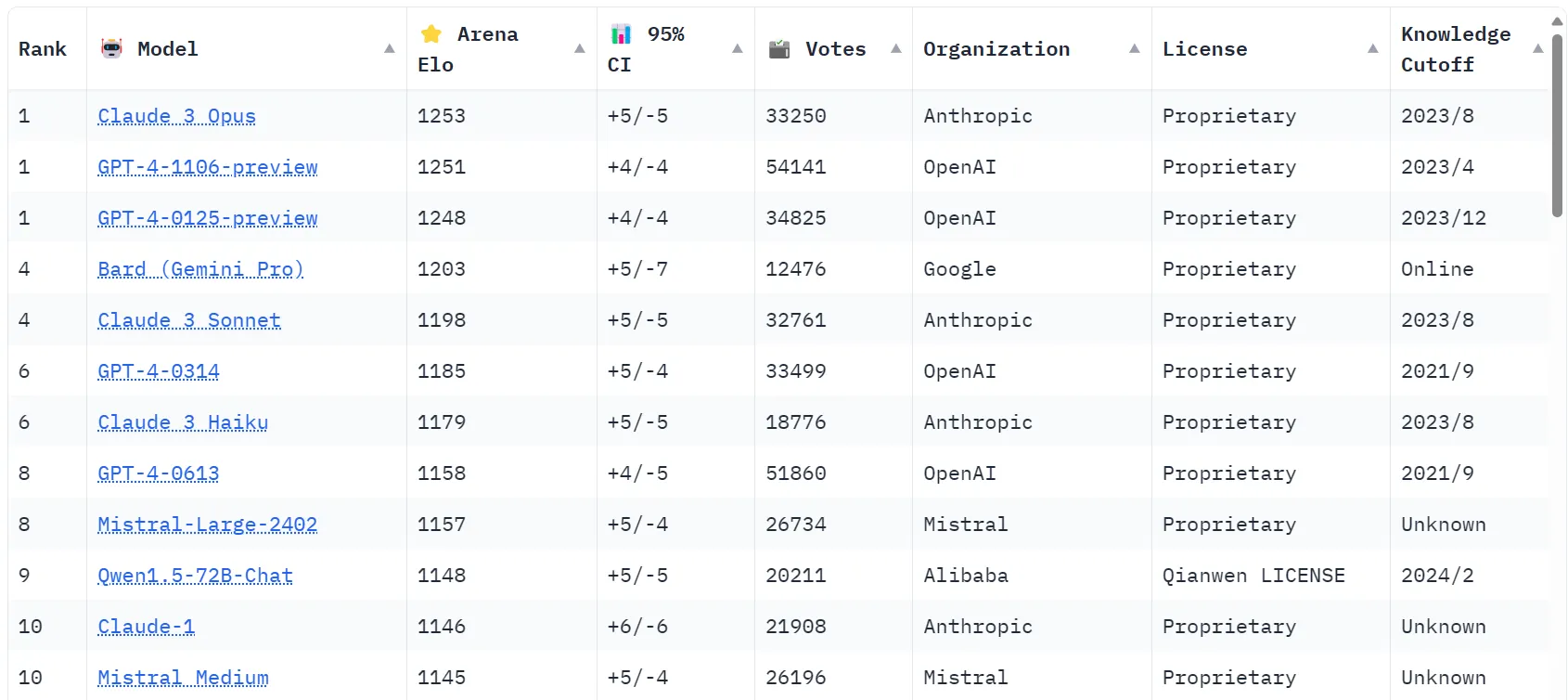

Claude 3 Opus de l'incontournable concurrent Anthropic a volé la première place à ChatGPT d'Open AI, qui bénéficie de la plus grande part d'esprit grand public de tous les outils d'IA générative, sur un tableau de bord populaire basé sur la foule utilisé par les chercheurs en IA.

L'ascension de Claude dans le classement de Chatbot Arena marque la première fois que le GPT-4 d'OpenAI, qui alimente ChatGPT Plus, a été détrôné depuis sa première apparition sur le tableau de bord en mai de l'année dernière.

Chatbot Arena est géré par Large Model Systems Organization (LMSYS ORG), une organisation de recherche dédiée aux modèles ouverts qui favorisent la collaboration entre les étudiants et le corps professoral de l'Université de Californie à Berkeley, de l'UC San Diego et de l'Université Carnegie Mellon. La plateforme présente aux utilisateurs deux modèles de langage non étiquetés et leur demande de noter celui qui fonctionne le mieux en fonction de critères qu'ils jugent appropriés.

Après avoir agrégé des milliers de comparaisons subjectives, Chatbot Arena calcule les modèles «meilleurs» pour le tableau de bord, le mettant à jour au fil du temps.

[Community creation]

Top-15 Chatbot Arena LLM ratings (May '23 - Now)Credit: Peter Gostev https://t.co/OgnLu3rj64 pic.twitter.com/Ueq7DZpu8N

— lmsys.org (@lmsysorg) March 27, 2024

marker Chatbot Arena est une ressource qualitative précieuse pour les chercheurs en IA.

La plateforme collecte les retours des utilisateurs et les soumet au modèle statistique de Bradley-Terry pour prédire la probabilité qu'un modèle particulier surpasse les autres en compétition directe. Cette approche permet la génération de statistiques complètes, y compris des intervalles de confiance pour les estimations de notation Elo - la même technique utilisée pour mesurer la compétence des joueurs d'échecs.

La montée de Claude 3 Opus au sommet n'est pas le seul développement significatif sur le classement. Claude 3 Sonnet (le modèle de taille moyenne disponible gratuitement) et Claude 3 Haiku (un modèle plus petit et plus rapide), également développés par Anthropic, occupent actuellement respectivement la 4e et la 6e place.

Le classement inclut différentes versions de GPT-4, telles que GPT-4-0314 (la version «originale» de GPT-4 de mars 2023), GPT-4-0613, GPT-4-1106-preview et GPT-4-0125-preview (le dernier modèle GPT-4 Turbo disponible via API à partir de janvier 2024). Selon le classement, Sonnet et Haiku sont tous deux meilleurs que le GPT-4 original, Sonnet dépassant également une version modifiée lancée par OpenAI en juin 2023.

Cela signifie également, malheureusement, qu'il n'y a actuellement qu'un seul LLM open source dans le top 10 : Qwen, avec Starling 7b et Mixtral 8x7B les seuls autres modèles ouverts dans le top 20.

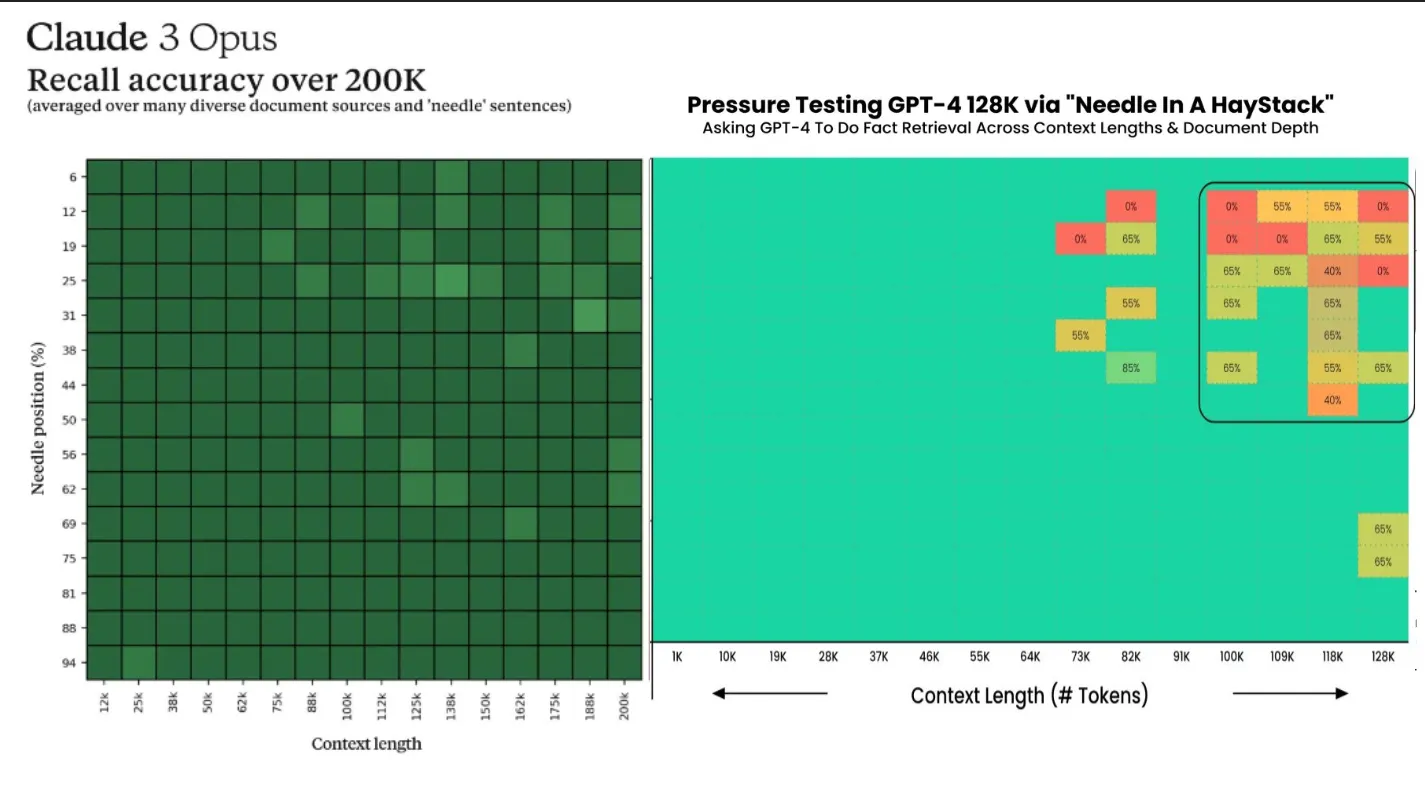

Un des avantages de Claude par rapport à GPT-4 est sa capacité de contexte de jeton et sa capacité de récupération. La version publique de Claude 3 Opus gère plus de 200 000 jetons - et l'organisation affirme avoir une version restreinte capable de gérer 1 million de jetons avec des taux de récupération presque parfaits. Cela signifie que Claude peut comprendre des invitations plus longues et retenir l'information de manière plus efficace que par rapport à GPT-4 Turbo, qui gère 128 000 jetons et perd ses capacités de récupération avec des invitations longues.

L'Gemini Advanced de Google gagne également du terrain dans l'espace des assistants IA. La société propose un plan qui comprend 2 To de stockage et des capacités d'IA dans la suite de produits Google pour le même prix qu'un abonnement Chat GPT Plus (20 $ par mois).

Le Gemini Pro gratuit est actuellement classé numéro 4, entre GPT-4 Turbo et Claude 3 Sonnet. Le modèle Gemini Ultra haut de gamme n'est pas disponible pour les tests et n'est pas encore présenté dans les classements.

Édité par Ryan Ozawa.